我正在通过以下命令运行 spark master:./sbin/start-master.sh

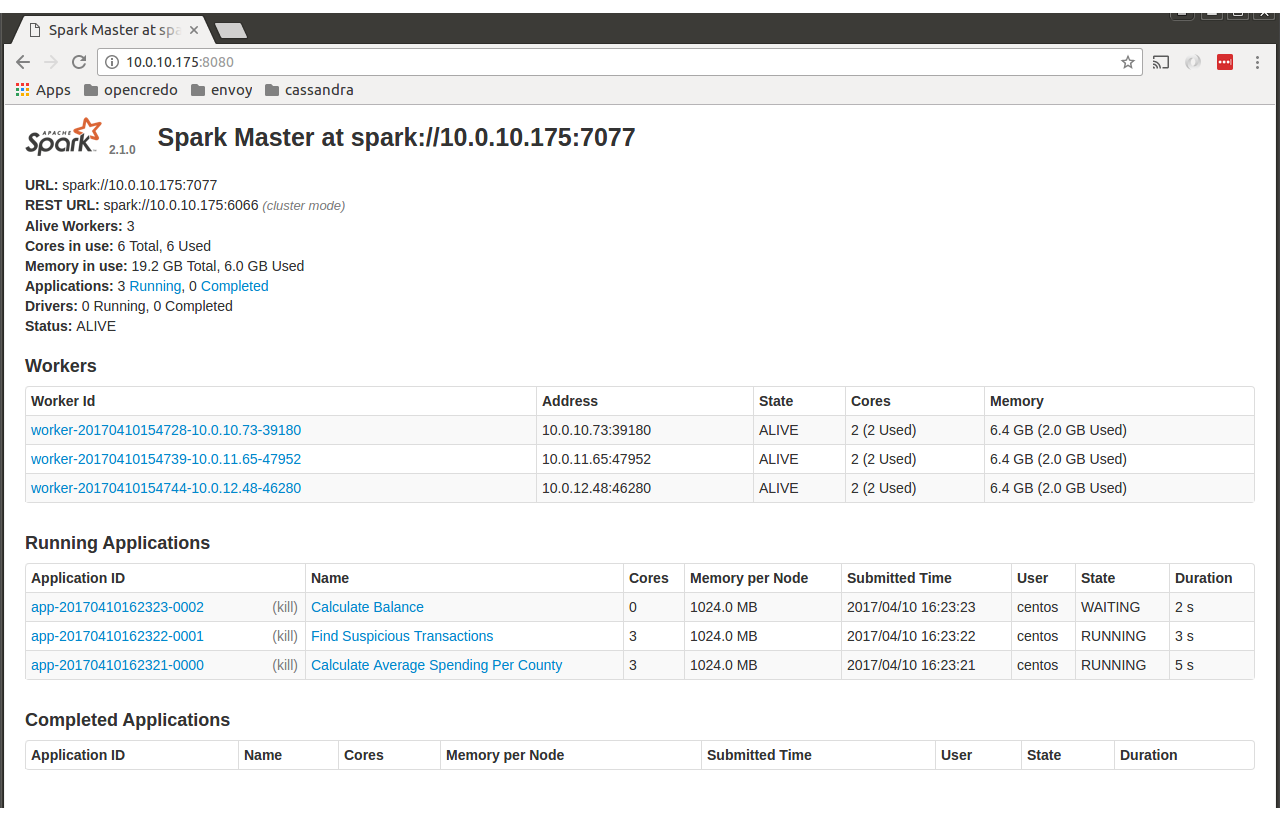

之后我去了http://localhost:8080 ,我看到了以下页面。

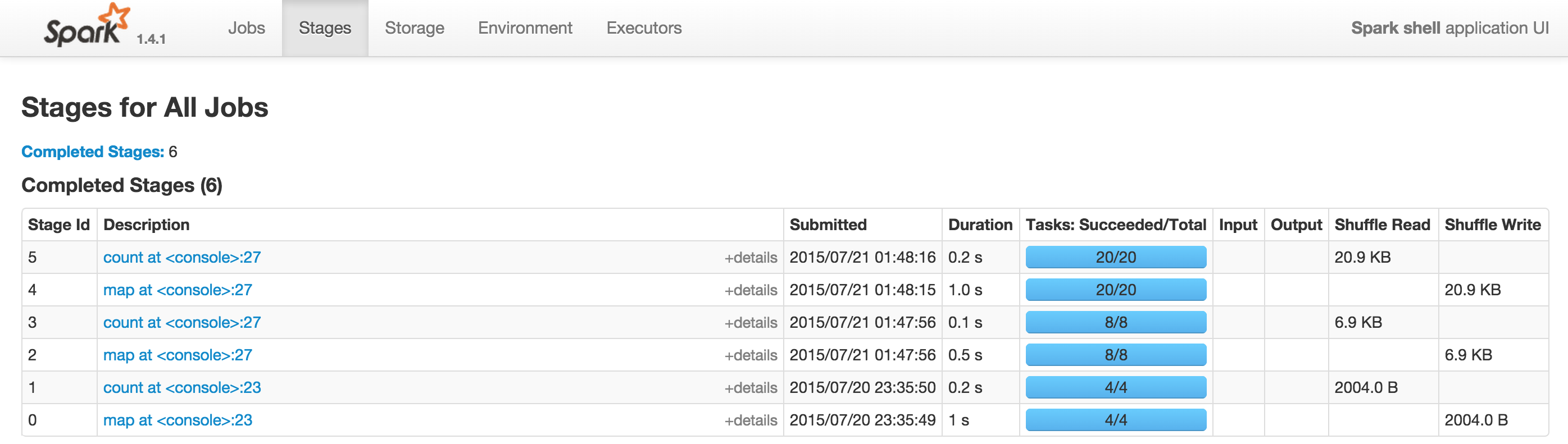

我期待看到带有“工作”、“环境”等的选项卡,如下所示

有人可以帮助我了解问题出在哪里吗?

我需要额外的配置吗?

谢谢

朱塞佩

最佳答案

要在 Web 浏览器中监视和检查 Spark 作业执行,请访问端口 4040 而不是 8080。

例如:http://ipAddress:4040

替换 URL 中的 8080。

引用:https://spark.apache.org/docs/latest/monitoring.html

在上面的链接中,spark 文档指出它在端口 4040 中启动了 Web 界面

一个更有用的说明是,默认情况下,此信息仅在应用程序期间可用。要事后查看 Web UI,请在启动应用程序之前将 spark.eventLog.enabled 设置为 true。这会将 Spark 配置为记录 Spark 事件,这些事件将 UI 中显示的信息编码到持久存储中。

希望有帮助。

关于apache-spark - 在独立模式下运行时,SparkUI 不显示选项卡(作业、阶段、存储、环境...),我们在Stack Overflow上找到一个类似的问题: https://stackoverflow.com/questions/56397738/