我已经配置了 3 节点 Spark 集群。并使用带有一些自定义属性的 start-thriftserver.sh 脚本启动 Spark Thrift 服务。并且还在集群的每个 spark-default.sh 文件中添加了 spark.executor.extraJavaOptions -XX:MaxPermSize=1024m -XX:PermSize=256m 属性。

使用 Hive JDBC 驱动程序,我能够连接到 spark-sql,并尝试了一些查询。

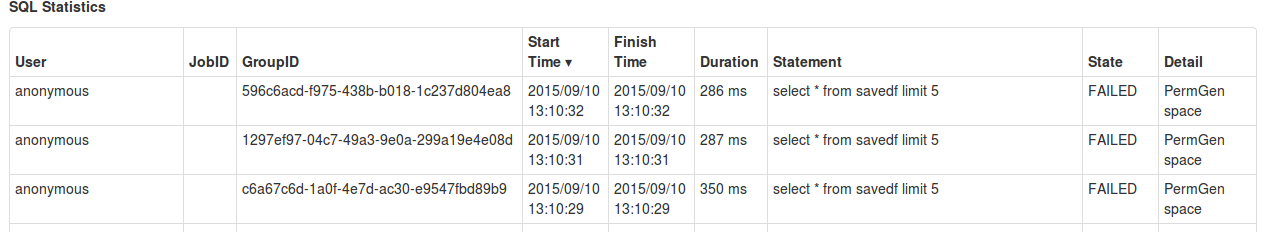

但一段时间后它会抛出 PermGen Space 错误。在多次重启节俭服务后,它抛出了同样的错误。

最佳答案

终于找到了解决方案。

我检查了应用程序日志,Spark 驱动程序发生了 permgen 错误,所以我添加了 -XX:MaxPermSize=1024m -XX:PermSize= 而不是 属性,带有 spark.executor.extraJavaOptions 选项256mspark.driver.extraJavaOptions 选项。

关于apache-spark - Spark Sql 抛出 PermGen 空间错误,我们在Stack Overflow上找到一个类似的问题: https://stackoverflow.com/questions/32497078/