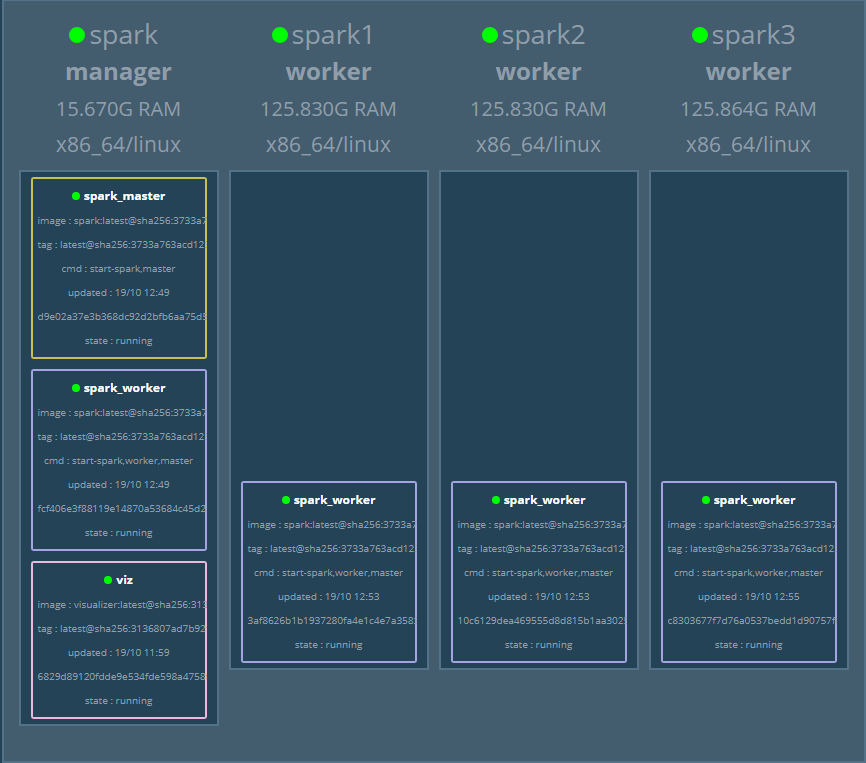

我们有一个由 docker swarm 构建的集群 集群由 1 Manager 3 Worker 节点组成。

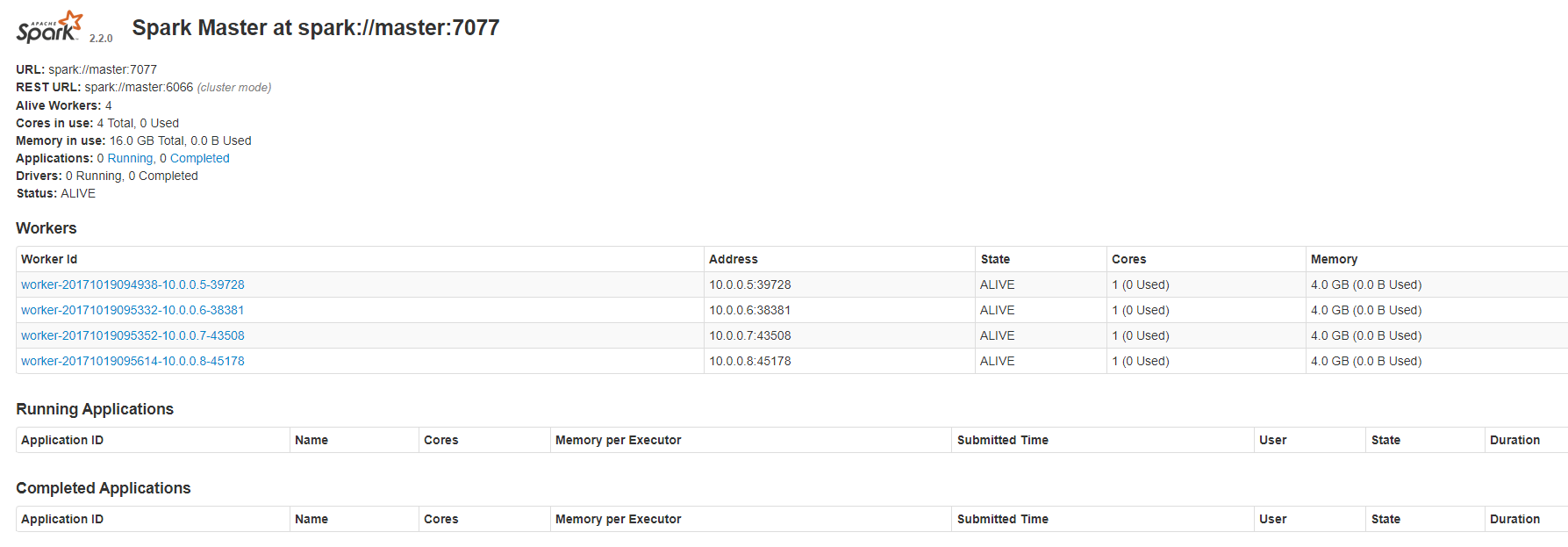

我们已经在集群上运行了 Apache Spark。它由一个主人和四个 worker 组成。在master web ui上可以看到如下

问题是我无法访问工作节点的详细信息。它想连接到一个 ip(10.0.0.5:8081)。但是我无法从我的本地计算机访问该链接。

最佳答案

需要绑定(bind)spark webui服务的端口,使用localhost:8081访问webui(如果绑定(bind)的是localport 8081) docker-compose.yml 文件中的示例 在 spark webui 服务中放这样的东西 https://docs.docker.com/compose/compose-file/#ports

您指定的 ip(10.0.0.5) 是 docker 创建的子网,您无法从您的计算机使用该 ip 访问

关于apache-spark - spark 中 worker 的 WebUI 访问,我们在Stack Overflow上找到一个类似的问题: https://stackoverflow.com/questions/46830018/